lun 19 août 2013

Ces derniers jours, suite à la sortie du classement dit « de Shanghai » des universités mondiales (« Academic Ranking of World Universities », ARWU), événement que la presse, tant en France qu’en Belgique, considère comme « très attendu et très controversé », j’ai été interviewé par plusieurs journalistes (Le Soir, L’Avenir, SudPresse). Comme toujours, la nécessaire concision des articles tronque le propos, efface les nuances et évacue le raisonnement sous-jacent, ce qui confère à mes déclarations un aspect tranché et catégorique, c’est la loi du genre. En outre, étant opposé au principe même de toute forme de classement d’universités, mon obstination à en dénoncer les effets pervers est généralement perçue comme une réaction de ‘mauvais perdant’. En fait, il n’en est rien:

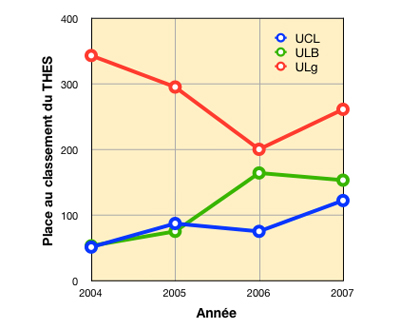

a) mon jugement sur les classements n’est pas neuf, je les dénonçais déjà en 2007,

b) non seulement mon avis n’a pas varié mais il serait rigoureusement le même si la position de l’ULg était meilleure (elle n’est d’ailleurs pas mauvaise du tout: le ‘top 300‘ sur des milliers d’universités, c’est évidemment très honorable, il suffit de feuilleter la liste de celles qui nous suivent, elle est édifiante…),

C’est pourquoi je pense nécessaire de m’expliquer quelque peu.

1. Qu’est-ce que le classement ARWU ?

Il existe entre 9.000 et 17.000 institutions dans le monde qui se considèrent comme universités, selon l’International Journal of Scientometrics, Infometrics and Bibliometrics. L’ARWU en retient environ 1.000 qui présentent une des caractéristiques suivantes*:

✔ avoir dans son personnel académique un ou des lauréats du Prix Nobel ou de la Médaille Fields (mathématiques);

✔ avoir des chercheurs fréquemment cités (?) ou ayant publié dans la revue Nature ou Science (données fournies par Webofknowledge.com);

✔ avoir un nombre significatif (?) d’articles publiés indexés par le « Science Citation Index-Expanded (SCIE) » et le « Social Science Citation Index (SSCI) » (données également fournies par Webofknowledge.com)

-

*: l’indication « (?) » est de moi et signifie que la définition n’est pas claire ou compréhensible

Ensuite, sur la base de principes méthodologiques dans lesquels intervient le nombre de membres du staff académique** (?), le classement retient environ la moitié de ces sélections, soit 500.

-

**: il faut préciser que « staff académique » n’a pas nécessairement la même signification dans les pays anglophones et chez nous où on pense « corps académique ». Il s’agit chez eux, en général, de toutes les personnes qui interviennent de près ou de loin dans la formation des étudiants.

Sur cette base est calculée une « Academic Per Capita Performance« , qui correspond au poids relatif des indicateurs que je viens de citer divisé par le nombre de membres du staff académique (en équivalents temps plein).

Un score très anglo-saxon

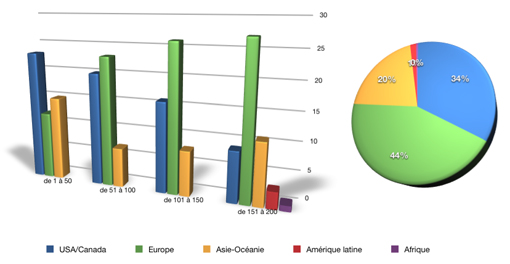

Les Etats-Unis placent 52 de leurs universités dans les 100 premières, le Royaume-Uni 9, l’Australie 5, la Suisse 4, le Canada 4, l’Allemagne 4, la France 4, le Japon 3, la Suède 3, les Pays-Bas 3, Israël 3, le Danemark 2, la Norvège 1, la Finlande, 1, la Russie 1 et la Belgique 1 (donc 32 pour l’Europe).

Pour la Belgique, on trouve l’Université de Gand (85ème), la KUL, l’UCL et l’ULB (toutes trois quelque part entre 101 et 200*), l’Université d’Anvers et l’ULg (toutes deux entre 201 et 300) et la VUB (entre 301 et 400).

-

*: à partir de la 101ème position, les résultats sont groupés dans l’ordre alphabétique par groupes de 50 et à partir de la 201ème, par groupes de 100.

2. Le principe du classement des universités est absurde.

Le seul fait de vouloir classer les universités sur base de leur « performance » est un non-sens: on ne peut effectuer un classement d’objets qu’à partir d’une valeur unique attribuée à chaque objet. Si on détermine, pour une même institution, plusieurs valeurs (par exemple pour des activités d’ordre différent: enseignement, recherche, relations avec le monde extérieur, rayonnement international, etc.), on génère nécessairement plusieurs classements parallèles et différents. Étant donné la complexité des activités accomplies par les universités, des dizaines de critères peuvent être pris en considération, ce qui implique des dizaines de classements différents. Les globaliser pour obtenir un classement unique est non seulement irréaliste, mais en totale contradiction avec la rigueur méthodologique que nous essayons de transmettre à nos étudiants.

Des missions très diverses.

Les universités accomplissent diverses missions, généralement rangées en 3 catégories: enseignement, recherche et service à la collectivité. On imagine facilement qu’une université puisse être très ‘performante’* en recherche et moins en enseignement. Ou l’inverse. En amalgamant ces deux missions, sans parler de la troisième, on mélange des pommes et des poires et on obtient un chiffre qui ne correspond à rien. En outre, on peut disserter à perte de vue sur la pondération à appliquer aux différents composants…

-

*: en admettant qu’on arrive à définir clairement la notion de performance à propos d’une université et à s’entendre sur ce terme. J’ai de sérieux doutes à cet égard…

Des domaines très divers.

Mais l’aberration ne s’arrête pas là. Non seulement les universités effectuent simultanément plusieurs missions, mais elles se spécialisent à un très haut niveau dans des domaines extrêmement variés. On sait que chaque institution ne présente pas la même excellence en tout, il existe donc, pour chacune d’entre elles, des spécificités fortes. Ici également, regrouper l’ensemble des domaines en une valeur moyenne n’a que peu de sens et masque les points forts.

Une analogie simple.

Pour mieux me faire comprendre, je vais recourir à une comparaison caricaturale. Imaginons que quelqu’un souhaite se lancer dans le classement des êtres humains et décrète que les indicateurs de qualité ou de performance sont:

1) la taille,

2) l’aptitude au calcul mental,

3) le temps de sprint sur 100 mètres,

3) le revenu mensuel brut,

4) la capacité d’ingurgitation de saucisses de Francfort en une heure,

5) le nombre de livres lus dans sa vie et

6) le nombre d’enfants.

Chaque indicateur présente un intérêt discutable et sujet à controverse. Le caractère ‘signifiant’ de ces critères peut évidemment être mis en doute individuellement: un critère peut être considéré par certains comme majeur et par d’autres comme sans intérêt, voire même négatif. Comment concilier ces avis? Et en supposant même que tout le monde soit d’accord, quelle pondération doit-on donner à chacun d’eux? Et finalement, quelle valeur aura la cote finale unique accordée à chaque individu, donc à son classement?

On aura compris que c’est là ‘mission impossible’. Plus un sujet d’observation est complexe et présente des caractéristiques variées et indépendantes (ou faiblement dépendantes), plus il est déraisonnable de vouloir simplifier son évaluation, et absurde de le faire en une seule notation.

La tentation d’apparaître.

Seulement voilà. L’être humain est terriblement demandeur de classifications dans tous les domaines. C’est le principe populaire du « hit parade »: élémentaire, confortable et rassurant.

Le premier classé est implicitement le ‘meilleur’ et le dernier est implicitement le ‘moins bon’. Le transfert vers la presse transforme l’implicite en explicite.

En outre, les classements piquent l’amour-propre. Après un tollé sonore provenant essentiellement des universités non anglophones, incontestablement dédaignées par tous les classements mondiaux, et un appel au boycott dans différents pays, on a assisté à des réactions visant à tenter de remonter dans les classements et d’y faire bonne figure. Dans ‘Le Monde’ du 15 août 2013, jour-même de la publication du classement de Shanghai, on lit: « L’université de Strasbourg (97e) intègre le Top 100 en raison du prix Nobel attribué, en 2011, à l’un de ses chercheurs, Jules Hoffmann. En 2012, cette distinction avait été ‘oubliée’ par le classement de Shanghai, qui a corrigé le tir après une protestation du ministère français de l’enseignement supérieur. L’Ecole normale supérieure de Lyon tire, elle aussi, le bénéfice de la médaille Fields attribuée, en 2010, au mathématicien Cédric Villani, et se place dans les 300 premières mondiales après que l’intéressé lui-même et le ministère eurent rappelé cette distinction à l’équipe de l’université Jiaotong. »

Mais attention: dès lors qu’elle cherche à rectifier ce qu’elle considère comme une erreur de positionnement dans le classement pour ce qui la concerne, une université accorde ipso facto une validation à la démarche de classement. Il lui devient ensuite impossible d’en contester le principe et la méthode. C’est un des pièges des « rankings ».

3. La méthode pose problème.

Considérons qu’il ne soit pas ou plus aujourd’hui possible de faire marche arrière. D’aucuns considèrent que puisque « ces classements existent, il faut bien les prendre en considération. » Je ne partage pas ce point de vue: ce n’est pas parce qu’un concept prévaut dans l’opinion qu’il faut s’aligner et l’adopter. Mais jouons le jeu. Analysons la méthode employée. Les choses ne s’arrangent pas…

Un choix de critères surprenant.

Même si on admet le principe et la nécessité de faire des classements, on est immédiatement frappé par le côté subjectif de l’analyse. Toute tentative d’objectiver le subjectif est périlleuse et souvent vouée a l’échec. Par son côté rassurant, l’objectivation, surtout si elle est numérique, se pare d’un caractère incontestable. Le leurre de l’objectivation par les chiffres fonctionne ici à plein. Mais on ne peut se priver de l’examen du bien fondé:

1) du choix des critères,

2) de la décision de leur attribuer une valeur positive ou négative,

3) du poids relatif à leur attribuer.

Les critères utilisés (Nobel/Fields, Nature/Science, SCIE/SSCI) sont étonnants, comme leur poids relatif. Le biais en faveur de l’activité de recherche est manifeste. Ça peut se défendre, mais il faut que ce soit clairement assumé.

Beaucoup de questions restent ouvertes: le nombre d’étudiants fréquentant l’université évaluée devrait-il être pris en compte? Si il l’est, constitue-t-il un élément positif, reflétant l’importance de l’institution? Ou négatif, en raison de la charge que ces étudiants représentent et qui distrait les encadrants de la recherche? Ce n’est pas clair.

Un journal m’a fait dire « les grosses universités avec beaucoup d’étudiants ont plus de chance d’être en haut du classement » Je n’ai pas dit ça et je ne le pense pas: les universités les mieux classées sont de loin les plus sélectives. Il y a moins d’étudiants à Harvard (19.000) qu’à l’ULg (22.000)! Mais il faut aussi mentionner que les droits d’inscription y sont 60 fois plus élevés… L’ULg n’a évidemment pas la prétention de jouer dans la même division que Harvard, une université qui jouit d’un prestige mondial exceptionnel lui assurant des enseignants et des étudiants hors-norme. Son nom est même devenu synonyme d’université de premier plan. Mais l’ULg et les autres universités belges la devanceraient certainement dans un classement qui serait basé sur l’ouverture sociale et l’accessibilité… En les alignant dans le même classement, on compare donc bien des pommes et des poires.

-

Nombre d’étudiants inscrits dans les 100 premières universités du classement ARWU (Radius-ULg). L’effet de nombre n’est guère significatif.

En fait de critères, le taux d’encadrement semblerait bien plus significatif, de même que les moyens financiers dont l’institution dispose, les facilités d’hébergement et de transport, l’accessibilité pour les personnes à mobilité réduite, les installations sportives gratuites ou peu coûteuses, le soutien pédagogique mis à disposition de l’étudiant, la qualité alimentaire des restaurants universitaires, la disponibilité de salles d’étude et d’équipement informatique, etc. (tout cela étant évidemment corrélé directement aux moyens financiers). Voilà une série de critères sur lesquels tout le monde s’accordera quant à leur contribution positive à l’évaluation. La difficulté surgit lorsqu’il s’agit d’affecter ces critères d’un facteur de pondération. L’encadrement est-il plus important que la disponibilité d’activités sportives? Ou est-ce l’inverse?

Admettons qu’on arrive à s’accorder là-dessus. Que dire de l’évaluation de l’enseignement? Ou de la recherche? Comment en choisir les critères? Comment déterminer le niveau? Qui le fait, et sur quelle base? Les enquêteurs de l’ARWU ne consultent personne dans les universités*, contrairement aux autres opérateurs comme QS ou THE qui établissent un dialogue. Ils obtiennent leurs informations auprès d’organismes tels que: « National Ministry of Education, National Bureau of Statistics, National Association of Universities and Colleges, National Rector’s Conference ».

On ne peut, dans ce cas, que fonctionner sur base de la réputation, et de l’oui-dire. Le classement devient alors totalement subjectif, lié au niveau d’introduction de l’université dans le cénacle des évaluateurs et l’efficacité de son lobbying.

-

*: en fait, depuis quelque temps, ils consultent sur certains points mais, curieusement, ne se servent pas des réponses pour établir le classement.

De nombreuses critiques.

Je ne suis évidemment pas le seul à dénoncer les travers méthodologiques des classements en général et de l’ARWU en particulier. L’ULB comme l’UCL se sont clairement exprimées. La revue Nature elle-même, pourtant prise en référence par l’ARWU, disait en 2007: « Experts argue that [the rankings] are based on dubious methodology and spurious data, yet they have huge influence. All current university rankings are flawed to some extent; most, fundamentally », Ioannidis et al. en 2007, Billaut, Bouyssou & Vincke en 2009 ou Samarasekera & Amrhein en 2010 en ont critiqué les multiples défauts. De son côté, l’Union Européenne s’est prononcée contre le biais anglophone et a annoncé en 2010 l’élaboration, sous son égide, d’une analyse critère par critère: U-Multirank.

4. Un classement, pour quoi faire?

La contestation argumentée du bien-fondé des classements en premier lieu, de la méthodologie appliquée ensuite, devrait avoir eu raison de leur existence et de leur validité, donc de leur intérêt. On constate que les classements sont utilisés pour des raisons diverses, pas nécessairement celles pour lesquelles ils ont été développés au départ. Cela va du choix des relations internationales et de la sélection de partenaires, jusqu’au choix d’une institution pour y faire ses études. En cela, le classement de l’ARWU est très mal adapté.

Mais ce n’est pas tout, un autre élément intervient, c’est l’interprétation qu’on leur donne. La presse présente généralement les choses de façon trop simple et il faut la comprendre: on lui sert un classement pré-mâché en lui laissant penser qu’il s’agit d’un travail scientifique rigoureux, objectif et incontestable (surtout s’il provient d’une université). C’est pourquoi le démontage qui précède est nécessaire.

Le très grand défaut d’un classement est qu’il laisse croire que le 50ème est ‘meilleur’ que le 51ème, ce qui est tout-à-fait contestable.

Dans le cas de l’ARWU 2013, le classement par blocs de 100 au delà de la 100ème place laisse penser qu’il existe des ex æquo. La manchette du Soir vendredi était éclairante à cet égard: « L’ULB désormais ex æquo avec l’UCL« . La journaliste les a vues toutes deux à la 101ème place, donc ex æquo entre elles et avec la KUL, confusion qu’on retrouve dans la video du Soir. En fait, personne ne sait si l’une n’est pas 101ème et l’autre 200ème…! Interprétation extrême, mais possible. De même, personne ne peut savoir si ce qui est considéré comme une stagnation de l’ULg en 201ème position n’est pas un progrès de la 300ème à la 201ème, ou peut-être l’inverse, une chute au sein du ‘peloton’ 201-300.

En fait, et toujours si on valide l’idée-même de classement, le fait de procéder par ‘paquets’ de 100 est, en soi, une assez bonne idée qui sera d’ailleurs, sous une autre forme, reprise par l’opérateur privé QS dans sa nouvelle formule annoncée: « QS Star« . Celle-ci accordera de 1 à 5 étoiles aux universités, une initiative intéressante, mais évidemment affublée des travers tant de principe que méthodologiques qui affectent les autres classements désormais ‘traditionnels’. Les ‘paquets’ permettent de neutraliser la tentation de donner une signification à des écarts infimes, bien plus ténus que ce que permet la méthode utilisée. Malheureusement, cet effet ne disparaît pas et est, au contraire, plus marqué aux limites entre les ‘paquets’. L’écart entre le 201ème et le 301ème n’est peut-être que de 1.

Le classement par pays.

Par ailleurs, prendre un vaste classement international de 500 universités et en extraire les belges pour en faire un ‘classement belge’ est tentant, mais méthodologiquement très discutable.

Un classement plus ciblé est aussi proposé par discipline. L’écueil de la diversité des matières est estompé dans ce cas, mais le reste des critiques continue à s’appliquer.

Des interprétations elliptiques.

Les conclusions des classements — parfois expéditives ou même erronées — que tire la presse internationale aggravent encore la situation. Elles donnent du crédit à la démarche et poussent les universités à réagir. On peut considérer que c’est une bonne chose et que cela sort les universités d’une autosatisfaction tranquille dans laquelle on les accuse parfois de se complaire. Personnellement, je suis en faveur des processus d’évaluation et il me semble normal que les universités s’y soumettent. Elles ne doivent cependant pas tomber dans le piège du prêt-à-penser et tenter, pour grimper dans les classements, d’améliorer des critères qui ne correspondent pas aux valeurs qu’elles se sont données. Le risque d’uniformisation selon les standards de valeur américains est évident et nous menace directement.

Un non-événement

Si l’on examine les dix derniers résultats du classement ERWU (2004-2013), on constate une grande stabilité:

• l’ULg a toujours été classée entre 201 et 300;

• l’UCL a toujours été classée entre 101 et 150;

• l’ULB a toujours été classée entre 101 et 150, sauf en 2012 (150-200);

• la KUL a toujours été classée entre 101 et 150;

• l’UGent a toujours été classée entre 101 et 150, sauf en 2004 (100è) et depuis 2010 (90è, 89è, 89è, 85è);

• l’UA a toujours été classée entre 201 et 300;

• la VUB a toujours été classée entre 301 et 400, sauf en 2005 et 2010-12 (401-500).

Par conséquent, hormis la croissance de l’UGent, les fluctuations de la VUB et un petit écart de l’ULB l’an dernier, en dix ans, rien de nouveau sous le soleil de Shanghai…!

5. Conclusion

Chaque institution doit se définir, en connaissance de cause, en vertu de ses points forts mais aussi des points faibles qu’elle doit déterminer objectivement. Elle doit se définir en fonction des caractéristiques qu’elle possède et celles qu’elle voudrait acquérir ou améliorer. Elle doit communiquer sur ces objectifs et éviter de laisser faire ce travail par un organisme extérieur insensible à la diversité culturelle qui reste essentielle dans le monde universitaire.